IT_World

[논문리뷰] GroupFace : Learning Latent Groups and Constructing Group-based Representations for Face Recognition (잠복 그룹 학습 및 얼굴 인식을위한 그룹 기반 표현 구성) 2장 본문

[논문리뷰] GroupFace : Learning Latent Groups and Constructing Group-based Representations for Face Recognition (잠복 그룹 학습 및 얼굴 인식을위한 그룹 기반 표현 구성) 2장

engine 2021. 5. 24. 12:044. Experiments

구현 세부 정보를 설명하고 실험 및 절제 연구를 광범위하게 수행하여 GroupFace의 효과를 보여준다.

4.1. Implementation Details(구현 세부 정보)

Datasets. 열차의 경우, 100K ID에 대해 약 10M의 이미지를 포함하는 MSCleb-1M [10]을 사용한다. MSCleb-1M 원본 데이터 세트의 노이즈가 있는 레이블 때문에, 3을 포함하는 정제 버전[7]을 사용한다.85K ID에 8M 이미지 제공 테스트를 위해 다음과 같이 9개의 일반적으로 사용되는 데이터 세트를 사용하여 실험을 수행한다.

• 5,749개의 ID에서 13,233개의 이미지를 포함하고 있으며 이 이미지로부터 6000개의 쌍을 제공하며, CALFW [46] 및 CPLFW [45]는 LFW에서 재구성된 데이터 세트

• 1,595개의 ID가 포함된 3,425개의 비디오로 구성된 YTF [37]. • 질문 1(MF1)에 대한 690K ID의 100만 개 이상의 이미지로 구성된 MegaFace [16]

• 500개의 피사체가 포함된 CFP-FP [27]. 각 피사체는 10개의 정면 영상과 4개의 종단 영상으로 구성

• 440개의 ID를 가진 12,240개의 이미지를 포함하는 AgeDB-30 [22]. • 67,000개의 얼굴 이미지, 7,000개의 얼굴 비디오 및 10,000개의 얼굴 이외의 이미지를 포함하는 IJB-B[36]

• 138,000개의 얼굴 이미지, 11,000개의 얼굴 비디오 및 10,000개의 비 얼굴 이미지를 포함하는 IJB-C [21]

Metrics. LFW [13], YTF [37], CALFW [46], CPLFW [45], CFP-FP [27], AgeDB-30 [22] 및 MegaFace [16]의 ID 쌍에 대한 검증 정확도를 비교한다. MegaFace [16] 식별 작업은 100만 개의 산란기로 1위 식별 정확도로 평가된다. IJB-B [36] 및 IJBC [21]에서 1e-4 ~ 1e-6의 특정 거짓 수용률(TAR@FAR)에서 참 수용률을 비교한다.

Experimental Setting. 두 눈, 코 및 두 입 모서리의 다섯 개의 얼굴 점을 사용하여 얼굴 영역을 뒤틀어 정규화된 얼굴 이미지[7, 19, 34](112 × 112)를 구성한다. ResNet-100[12]을 최근 연구와 유사한 백본 네트워크로 사용한다[7, 14]. BN-FC 블록에 의해 활성화를 벡터화하고 # 활성화를 4096(그림 2의 공유 기능)으로 줄였다.

GroupFace는 ResNet-100의 res5c 다음에 부착되며, 여기서 활성화 치수는 512x7x7이다. GDN의 MLP는 BN-FC와 그룹 분류를 위한 FC의 두 블록으로 구성된다. [7, 34]에 따라 손실 함수의 하이퍼 파라미터를 설정한다.

Learning. 8개의 동기화된 GPU와 GPU당 128개의 이미지를 포함하는 미니 배치로 모델을 훈련시킨다. 그룹 페이스의 네트워크는 소프트맥스 기반 손실만으로 훈련된 사전 훈련된 네트워크로부터 훈련된다. [7, 34] 처음 50k에 대해 0.005의 학습률을, 20k에 대해서는 0.0005의 체중 감퇴와 확률적 경사 하강(SGD)에 0.9의 운동량을 가진 10k에 대해 0.00005의 학습률을 사용했다. 모든 GPU에서 128 × 8 샘플의 그룹 확률을 계산하고 모집단에 대한 그룹 확률의 기대를 정확하게 추정하기 위해 최근의 B 배치에 대한 기대치를 평균함으로써 그룹 확률의 기대를 계산한다. 32에서 128 사이의 B는 경험적으로 유사한 성능을 보여준다.

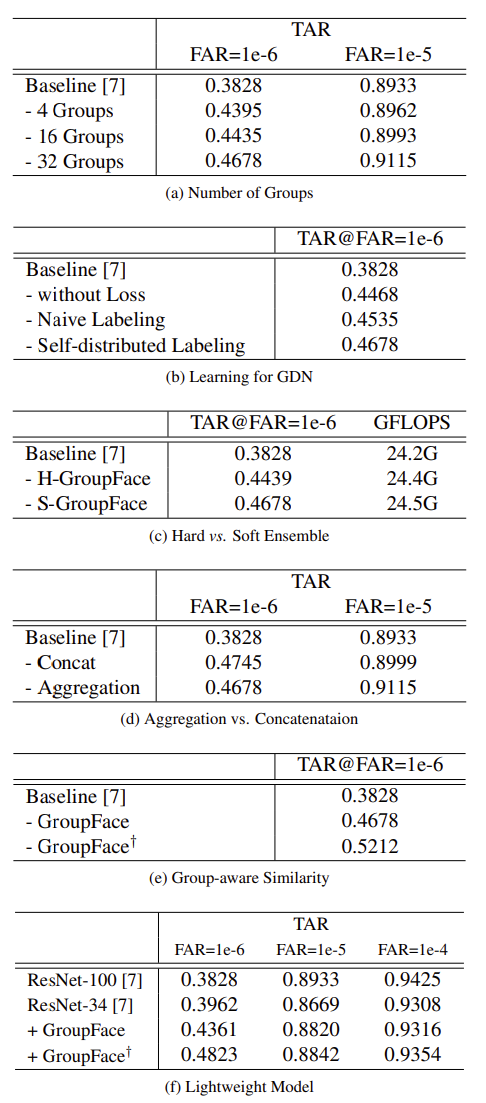

Aggregation vs. Concatenation. 인스턴스 기반 표현과 그룹 인식 표현을 하나의 임베딩 기능(표 1d)인 (1) 집계 및 (2) 연결로 결합하는 방법을 비교한다. 연결 기반 GroupFace는 더 나은 TAR@를 보여준다.FAR=1e-6은 Aggregation 기반 GroupFace보다 0.67% 포인트 더 우수하지만 Aggregation 기반 GroupFace는 TAR@FAR=1e-5x1.16%포인트다. 일반적으로 더 적은 기능 차원으로 더 나은 성능을 제공하는 Aggregation 기반 GroupFace를 선택했다.

Group-aware Similarity. 인식 성능은 그룹 인식 유사성을 평가함으로써 다시 한 번 크게 개선된다(표 1e). 그룹 인식 유사성은 유사성 계산에 필요한 기능 차원을 증가시키지만, 기능이 인식 네트워크의 중간 출력이기 때문에 필요한 기능을 추출하기 쉽다. 특히, 이 실험은 그룹 기반 정보가 실제 사용에서 성능을 향상시킬 수 있을 만큼 기존의 ID 기반 정보와 구별된다는 것을 보여준다.

Lightweight Model. GroupFace는 ResNet-34[12]와 같이 24.2 GFLOPS가 필요한 ResNet-100[12]보다 8.9 GFLOPS만 필요로 하는 경량 모델에도 효과적이다. ResNet-34 기반 GroupFace는 ResNet-100 기반 ArcFace[7]와 유사한 성능을 보이며 가장 어려운 기준(FAR=1e-6)에서 ResNet-100을 크게 능가한다. 또한 그룹 인식 유사성은 ResNet-34 모델의 기본 성능을 크게 초과한다(표 1f).

4.3. Evaluations

LFW, YTF, CALFW, CPLFW, CFP-FP 및 AgeDB30. LFW[13] 및 YTF[37]의 검증 정확도를 라벨이 부착된 외부 데이터 프로토콜과 제한되지 않은 것과 비교한다(표 2). YTF에서 이미지 시퀀스에서 노이즈가 있는 이미지를 제외하지 않고 모든 이미지를 평가한다. 두 데이터 세트가 모두 고포화 상태임에도 불구하고, GroupFace는 다른 최신 방법을 능가한다. 또한 LFW(CALFW [46], CPLFW [45]), CFP-FP [27] 및 AgeDB-30 [22]의 변형에 대한 검증 정확도를 보고한다(표 3). GroupFace는 위의 모든 데이터 세트에서 더 나은 정확도를 보여준다.

MegaFace. 메가페이스 [16](표 4)에서 0.5M 이상의 이미지를 포함하는 교육 세트를 사용하여 모델을 학습하는 대규모 교육 세트 프로토콜로 그룹페이스를 평가한다. GroupFace는 최근 발표된 최첨단 방법 중 최상위 얼굴 인식 모델이다. 정제된 MegaFace [7]에서 GroupFace는 다른 모델보다 성능이 우수하다.

IJB-B and IJB-C. 제안된 방법을 IJB-B[36] 및 IJB-C[21] 데이터 세트에 대한 다른 방법과 비교한다(표 5). 최근의 각도 여유 소프트맥스 기반 방법[7, 34]은 데이터 세트에서 우수한 성능을 보여준다. 수평 뒤집기와 같은 테스트 시간 증강 없이 CosFace[34]와 ArcFace[7]를 기반으로 한 검증 정확도에서 GroupFace의 개선을 보고한다. 그룹 페이스는 모든 FAR 기준에서 IJB-B의 ArcFace[7]와 FAR=1e-6의 8.5% 포인트, FAR=1e-5의 1.8%, FAR=1e-4의 0.2% 포인트, FAR=1e-2%의 4.3% 포인트 향상되었습니다. 인식 성능은 그룹 인식 유사성(Eq.5), 특히 IJB-B의 가장 어려운 기준(TAR@FAR=1e-6)을 5.3% 포인트 적용함으로써 다시 크게 향상된다.

4.4. Visualization

제안된 방법의 효과를 보여주기 위해 특징 표현, 그룹의 평균 활성화 및 그룹의 시각적 해석을 시각화한다.

2D Projection of Representation. 그림 4는 (a) 기준 네트워크의 최종 표현(ArcFace [7]), (b) GroupFace의 인스턴스 기반 표현 및 2D 공간에서 GroupFace의 최종 표현 간의 정량적 비교를 보여준다. 정제된 MSCleb-1M 데이터 세트에서 처음 8개의 ID를 선택하고 t-SNE[20]를 사용하여 추출된 형상을 각도 공간에 매핑한다. 정량적 비교를 통해 제안된 모델은 기준 모델보다 더 뚜렷한 특징 표현을 생성하고 또한 제안된 모델은 인스턴스 기반 표현을 향상시킨다는 것을 알 수 있다.

Activation Distribution of Groups. 제안된 SelfGrouping은 샘플이 모든 그룹에 고르게 확산되도록 노력하고, 동시에 소프트맥스 기반 손실도 GDN으로 그레이디언트를 동시에 전파하여 식별이 가장 잘 작동하도록 한다.

따라서 확률 분포가 정확하게 균일하지 않습니다(그림 5). 일부 그룹의 확률은 낮고 다른 그룹의 확률은 높다.(ex: 1, 2, 5, 6, 14, 15, 17, 18, 28, 29, 30, 31번째 그룹) 전체 분포가 예상했던 것처럼 균일하지는 않지만, 높은 활성 그룹 중에서는 지배적인 분포가 없다는 것을 알 수 있다.

Interpretation of Groups. 훈련된 잠재 그룹은 안면 속성(예: 머리, 안경 및 콧수염)이 아닌 잠재 기능을 사용하여 GDN의 비선형 함수에 의해 분류되기 때문에 항상 시각적으로 구별할 수 있는 것은 아니다. 그러나 두 가지 그룹의 경우(그림 6의 그룹 5와 20) 시각적 특성을 명확히 볼 수 있다. 랜덤하게 선택된 100개의 이미지 중 95개는 그룹 5의 남성이고 랜덤하게 선택된 100개의 이미지 중 94개는 그룹 20의 대머리 남성이다. 다른 것들은 하나의 시각적 속성으로 묘사되지 않지만, 그들은 미소녀, 올바른 인물, 그리고 그룹 1의 겁먹은 사람들과 같은 여러 시각적 속성으로 묘사되는 것처럼 보인다.

5. Conclusion

그룹 인식 네트워크 구조와 여러 잠재 그룹 인식 표현을 효과적으로 조작하기 위한 자체 분산 그룹화 방법으로 구성된 새로운 얼굴 인식 전문 아키텍처를 소개한다. 절제 연구와 실험을 광범위하게 수행하여 GroupFace의 효과를 입증한다. 또한 시각화는 GroupFace가 기존 방법보다 기능 표현을 근본적으로 향상시킨다는 것을 보여주며 잠재 그룹은 몇 가지 의미 있는 시각적 설명을 가지고 있다. GroupFace는 기존 인식 시스템에 실질적으로 적용 가능한 인식 성능에서 상당한 개선을 제공한다.

GroupFace의 효과에 대한 근거는 크게 두 가지로 요약된다.

(1) 다른 목표의 추가 감독이 특징 추출 네트워크를 공유함으로써 주어진 작업의 개선을 가져올 수 있다는 것은 잘 알려져 있다. 예를 들어, 분할 헤드가 객체 감지 정확성을 향상시킬 수 있다[2, 11]. 마찬가지로, 그룹을 학습하는 것은 얼굴 인식을 위해 보다 일반화된 특징 추출기를 훈련시키는 데 도움이 될 수 있다.

(2) GroupFace는 인스턴스 기반 표현과 그룹 기반 표현을 융합하는 새로운 구조를 제안하며, 경험적으로 그 효과가 입증되었다.

원문 : https://arxiv.org/pdf/2005.10497.pdf